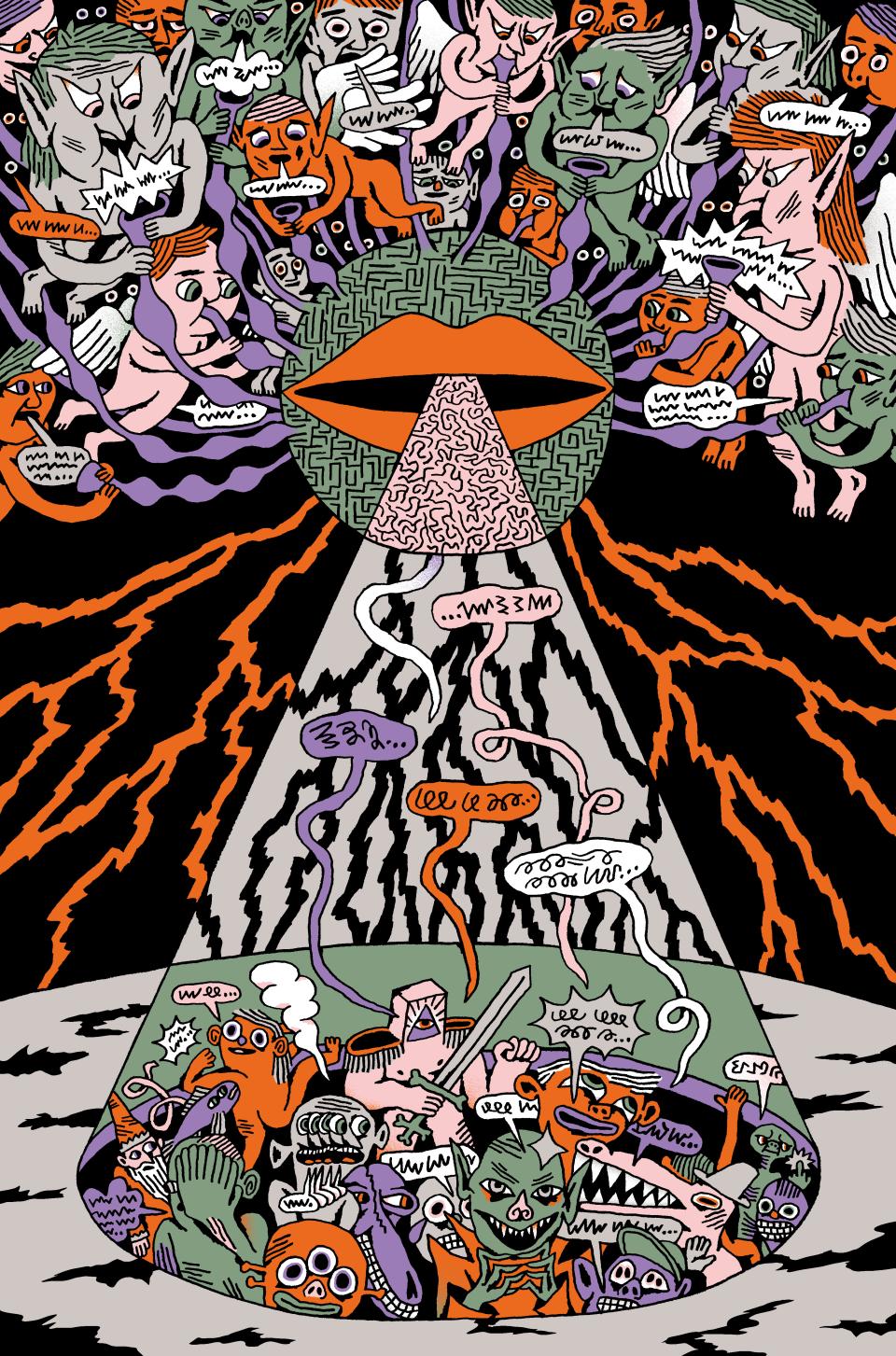

Chat GPT: Wenn der Chatbot zur Cyberwaffe wird

Generative KI hat gelernt zu kommunizieren und greift in öffentliche Debatten ein. Das birgt grosse Risiken. Die Techfirmen, die hinter dieser Entwicklung stehen, sollten dabei nicht aus dem Blick geraten.

Chat GPT hat den Turing-Test obsolet gemacht: Es geht nicht mehr um die Frage, ob der Chatbot den Test bestehen würde, also einem Menschen vormachen könnte, selbst ein Mensch zu sein. Sondern um die Tatsache, dass Milliarden von Menschen innert kürzester Zeit und routinemässig mit der Sprach-KI zu interagieren begonnen haben, als wäre sie ein menschliches Wesen. Chat GPT ist zum Inbegriff einer disruptiven Technologie geworden – mit noch weitgehend unabsehbaren gesellschaftlichen Folgen.

Als sogenannte generative KI (vgl. «Die KI hinter Chat GPT») kann Chat GPT nicht nur Muster in Datensätzen erkennen, wie es traditionelle KI-Modelle tun, sondern selbst neue Inhalte schaffen. Mit der vieldiskutierten allgemeinen künstlichen Intelligenz hat das insofern zu tun, als umso deutlicher wird, dass «Intelligenz» für KI grundsätzlich die falsche Bezeichnung ist. Denn die Modelle sind nicht im menschlichen Sinne intelligent – sie korrelieren Wahrscheinlichkeiten, im Fall von Sprach-KI die Abfolge von Wörtern und Sätzen. Sie besitzen keine Vorstellung von den Phänomenen, die in ihren Antworten zum Ausdruck gelangen, und verfügen weder über Kritikfähigkeit noch Moral noch einen eigenen Willen. Umgekehrt gilt: Die Modelle funktionieren auf eine Art und Weise, die für Menschen nicht verständlich oder auch nur nachvollziehbar wäre – daher ihre Bezeichnung als Blackbox.

Die KI hinter Chat GPT

Im Unterschied zu diskriminativer künstlicher Intelligenz (KI), die zur Klassifikation von Datensätzen eingesetzt wird, kann generative KI auf der Basis solcher Datensätze neue Inhalte kreieren. Eigentlich handelt es sich dabei um ein Large Language Model (LLM), das mithilfe von künstlichen neuronalen Netzwerken und Deep Learning natürliche Sprache verarbeiten kann. Dabei verknüpft der Algorithmus das auf der Basis vorhandener Informationen Erlernte immer wieder mit neuen Inhalten, um daraus Prognosen oder Entscheidungen zu treffen, die ihrerseits bestätigt oder in einem neuen Anlauf geändert werden. All dies geschieht ohne menschliches Eingreifen. Erst mittels Finetuning wird von aussen versucht, die Antworten respektive Resultate zu verbessern oder auf spezifisch gewünschte Inhalte masszuschneidern, indem mit neuen Datensätzen trainiert und die Gewichtungen von Entscheidungen verändert werden.

«Systeme wie Chat GPT erreichen ihre erstaunliche Leistung nicht, weil sie endlich intelligent geworden sind, sondern gerade, weil sie nicht versuchen, es zu sein», schreibt die italienische Soziologin Elena Esposito. Sie tun «etwas, das Menschen aufgrund ihrer Intelligenz tun: Sie kommunizieren!» Insofern messe der Turing-Test auch nicht die Intelligenz von KI-Modellen, sondern ihre Fähigkeit, in Kommunikation einzugreifen. Genau darauf sollten wir unseren Fokus richten, fordert die Schülerin von Umberto Eco und Niklas Luhmann in ihrem Essay «Kommunikation mit unverständlichen Maschinen» (Residenz-Verlag, 2024). Denn die Auswirkungen auf unsere Gesellschaft hängen davon ab, wie generative KI das tut.

Die Folgen trägt die Gesellschaft

Wobei man zuerst einmal festhalten sollte, dass hinter der disruptiven Gefahr von generativer KI ganz konkrete Akteure stehen: jene Handvoll Techkonzerne, zu denen auch die Firma Open AI gehört, die Chat GPT entwickelt hat. Open AI hat ein vehementes Eigeninteresse daran, dass die Blackbox auch eine bleibt. «Open» im Sinn von transparent sind weder die Firma noch ihr Produkt. Im Gegenteil: Die Trainingsbasis von Chat GPT gehört ebenso zu den gut gehüteten Geheimnissen wie der Algorithmus und dessen Veränderungen mittels Finetuning.

Gleichzeitig schüren die Techkonzerne öffentlich die Vorstellung von einer imminenten «Superintelligenz», die sich gegen uns wenden könnte. Dabei vermenschlichen sie diese konsequent – auf dass wir uns weiterhin vor ihrer massiven «geistigen» Überlegenheit fürchten: Chat GPT vermöge beim Lernen aus den Milliarden von Daten in der Trainingsbasis die «Essenz einer Idee» herauszukristallisieren, behauptet Ilya Sutskever, der verantwortliche Entwickler der Sprach-KI. Indem sie vorhersage, was als Nächstes folge, zeige sie, dass sie die Welt «verstehe». Angesichts solcher «Superintelligenz» einen Marschhalt in der Weiterentwicklung fordern und hinter den Kulissen ungerührt daran weiterarbeiten: Damit lenken die Techkonzerne nur vom zentralen Problem ab, nämlich ihrer Monopolstellung rund um generative KI, deren negative Folgen sie der Gesellschaft aufbürden.

Zum Beispiel den exzessiven Energiebedarf. Chat GPT und Co. benötigen enorme Rechenkapazitäten, über entsprechend leistungsstarke Serverfarmen verfügen aber einzig die US-Techgiganten. Öffentliche Forschungseinrichtungen haben keine Chance, in dieser Entwicklung mitzuhalten. Die Internationale Energieagentur (IEA) schätzt, dass sich der Stromverbrauch der KI-Industrie innert dreier Jahre verzehnfachen wird. Bereits eine Anfrage – ein sogenannter Prompt – an Chat GPT verschlingt zehnmal mehr Strom als eine einfache Google-Suche.

Enorm gefrässig zeigen sich die Konzerne auch in Bezug auf Daten. Dass Open AI für das Training von Chat GPT massenhaft auf urheberrechtlich geschütztes Datenmaterial im Netz zurückgreift, hat der Firma schon mehrere Klagen eingetragen, unter anderem von der «New York Times». Anfang Jahr hat Open AI einen App-Store für bezahlende Abonnent:innen von Chat GPT Plus, den GPT-Store, aufgeschaltet, in dem diese ihre personifizierten Versionen des Chatbots zugänglich machen können. Sämtliche damit verbundenen Daten saugt Open AI für eigene Zwecke ab. Seit Februar erstellt die Firma zudem aus dem Chatverlauf aller Chat-GPT-Nutzer:innen ein persönliches Profil, das im sogenannten Memory gespeichert wird und hochsensible Daten zu Familie, Beziehungen, Tätigkeiten und persönlichen Präferenzen enthält. Das Datenschutzteam der Technischen Universität Berlin rät dringend, die Memory-Funktion zu deaktivieren, auch wenn dadurch die Qualität der Antworten leidet.

Wer (wird) manipuliert?

Denn das disruptive Potenzial von generativer KI gründet nicht zuletzt darin, dass sie ein wachsendes Sicherheitsrisiko darstellt. Chat GPT und Co. lassen sich extrem einfach und ohne Programmierkenntnisse manipulieren und missbrauchen. Dazu genügt ein Blick in den GPT-Store von Open AI: Wie die «Netzwoche» Ende März berichtete, häuft sich dort Spam, viele der angebotenen Apps sind justiziabel – wofür Open AI nicht einmal haftbar gemacht werden kann.

Immer mehr wissenschaftliche Studien, basierend auf sogenannt ethischem Hacking oder Red Teaming, legen Sicherheitslücken in Computersystemen offen. Sie machen etwa deutlich, wie simpel Chat GPT zur Cyberwaffe umfunktioniert werden kann, mit indirekten Prompts etwa, die in den Chatbot eingebaut und später mit einem Prompt aktiviert werden. Selbst Laien können sich so Zugang zu Netzwerken von Firmen und Organisationen verschaffen, um Daten zu klauen, Schadsoftware einzuschleusen oder gar die Kontrolle zu übernehmen. Die ETH Zürich betreibt mittlerweile eine eigene Red-Teaming-Abteilung, das Spy Lab, wo erst getestet wird, wie krass sich generative KI manipulieren lässt, um danach Wege zu suchen, dies zu verhindern.

Die Manipulation funktioniert auch umgekehrt, indem wir uns vom Chatbot in die Irre führen lassen: von der Autorität, mit der er antwortet, selbst wenn er den grössten Schwachsinn verkündet. Dabei ist eigentlich längst bekannt, dass generative KI-Modelle nicht nur «halluzinieren», also Antworten erfinden, sondern dass diese auch «biased», also verzerrend bis diskriminierend, sein können. Das liegt einerseits in der Datenbasis begründet, mit der sie trainiert werden, andererseits im Trainings- respektive Lernprozess selber, wo das Erkennen und das Verstärken von Stereotypen zum Prinzip gehören. Im medizinischen Bereich kann eine Diskriminierung, im Sinn von Differenzierung, nach Geschlecht oder ethnischer Herkunft viele Vorteile bringen, wohingegen sie sich im gesellschaftlichen Kontext meist negativ auswirkt.

Was zurück zum Problem der Blackbox führt: Wie lässt sich eine generative KI kontrollieren, wenn wir nicht verstehen, was sie macht, und die Resultate erst im Nachhinein, wenn überhaupt, verifizieren können? Erste Ansätze dazu kommen aus der Forschung zu Explainable Artificial Intelligence (XAI) – also erklärbare KI – und bauen auf der Kommunikationsfähigkeit der Modelle auf. Ziel ist, wie Elena Esposito es formuliert, eine Art Metakommunikation über die Prozesse oder verwendeten Daten zu etablieren und aus dem, was die KI über diese kommuniziert, Informationen abzuleiten, die eine Form von Kontrolle ermöglichen.

Führerschein fürs Chatten mit KI

Geht es um das disruptive Potenzial für Gesellschaft und Demokratie, ortet Esposito vor allem Gefahr, wo generative KI in öffentliche Debatten eingreift und alternative Realitäten schafft. Wenn durch sie Fake News einfach und billig produziert und massenhaft verbreitet werden könnten, untergrabe dies die Glaubwürdigkeit etablierter Medien. Deepfakes würden das Problem noch verschärfen, weil sie nicht einfach falsche Informationen über die Realität vermittelten, sondern wahre Informationen über eine fiktive Realität, die von einer KI erzeugt werde.

Solange Techkonzerne aber jede Form von Transparenz in Bezug auf die Trainingsdatenbasis und die Algorithmen ihrer KI-Modelle verweigern, wird die öffentliche XAI-Forschung immer im Hintertreffen bleiben, weil sie für ihre Analysen nur auf veraltetes Material zurückgreifen kann, das die Konzerne freigeben, weil sie es nicht länger verwenden. ETH und Bund versuchen, mit ihrem kürzlich lancierten «Swiss Call for Trust and Transparency» eine Gegenmacht aufzubauen.

Und solange die Techkonzerne für ihre Produkte nicht juristisch haftbar gemacht werden, bleibt den Nutzer:innen von Chat GPT und Co. nur, in der Kommunikation mit diesen Maschinen ihren kritischen Verstand nicht vorschnell wegzulegen oder an diese zu delegieren. «Wir brauchen so etwas wie einen Führerschein für generative KI», sagt die XAI-Forscherin Menna El-Assady (vgl. «‹Chat GPT hat keine Ahnung von Logik›»).

Esposito ist mit Blick in die Geschichte zuversichtlich: Unsere Zivilisation habe bereits früher vor vergleichbaren Herausforderungen durch neue disruptive Kommunikationstechnologien gestanden, die Entwicklung der Schrift etwa, durch die sich das Auswendiglernen erübrigte, oder die Erfindung des Buchdrucks. Im Grunde könnten wir also damit umgehen lernen.

Kommentare

Kommentar von Whakahoatanga

Do., 25.04.2024 - 12:21

Toller Artikel. Eure Artikel über neue Technologien finde ich immer fantastisch. Ich finde eh, dass diese LLM überbewertet werden. Wird noch gefährlich enden.